Import.io

Herramientas como import.io te permiten realizar scraping desde los más sencillos en formato CSV o JSON, hasta los más complejos como construir una API desde tu navegador a partir de los datos del sitio Web al que te interesa aplicar el Web Scraping; esto, sin saber de programación. Por medio de esta herramienta puedes lograr, por ejemplo, la programación de extracción de forma periódica o manual de datos y la utilización de esos datos recuperados en tus apps, alertas de novedades, modelos y visualizaciones.

Para usar esta forma de Scraping debes seguir los siguientes pasos:

Paso 1

Ingresa al navegador de tu preferencia Y abre la dirección Web indicada a continuación:

Paso 2

Regístrate totalmente gratis, con las opciones de redes sociales o mediante el correo electrónico e inicia sesión en la Web de import.io.

Dentro del entorno de import.io verás algo similar a la ventana de abajo.

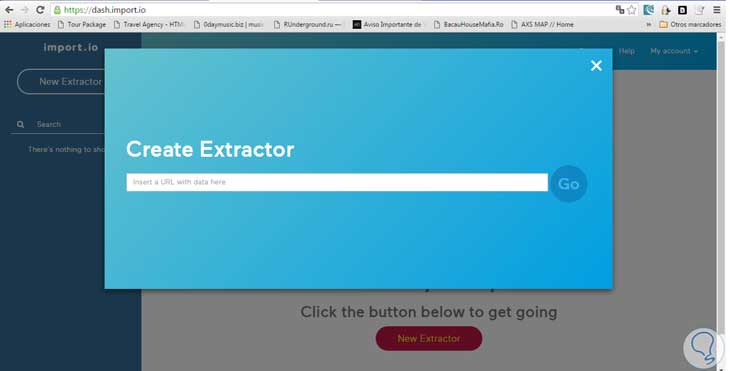

Paso 3

Haz clic en el botón New Extractor, el cual nos mostrará una ventana como la siguiente:

En el campo de la URL debes escribir el sitio Web del cual obtendremos los datos (usemos la dirección del ejemplo anterior: http://www.realmadri...l-madrid/agenda.

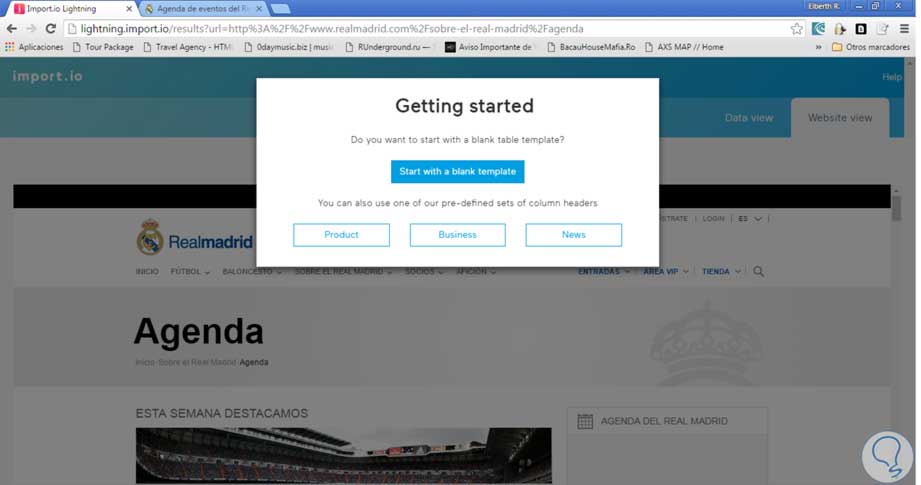

Una vez hecho esto, presiona el botón Go. Se desplegará una ventana como la mostrada a continuación, donde puedes seleccionar la forma en que se seleccionarán las columnas, ya sea una plantilla en blanco u otras 3 opciones:

- Product

- Business

- News

En este caso, seleccionamos Blank Template.

Paso 4

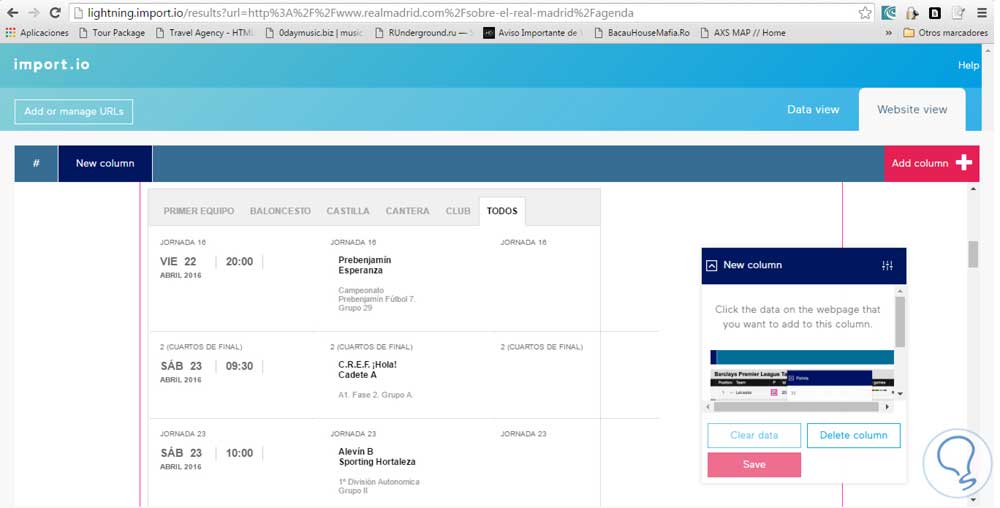

La interfaz de trabajo será la siguiente:

Aquí como puedes ver, podemos ir seleccionando cada elemento de la página y asignarlo para que sean almacenadas en una columna.

Para este ejemplo hacemos clic en New Column y le ponemos un nombre, en este caso utilizamos fechas. Luego en la página hacemos clic en cada una de las fechas de esa tabla, al hacer clic en las 2 primeras, verás automáticamente que se seleccionarán todas las demás. Luego seleccionamos el botón Save.

Paso 5

Si deseamos ver cómo está quedando nuestra data seleccionada, simplemente hacemos clic en la pestaña Data View.

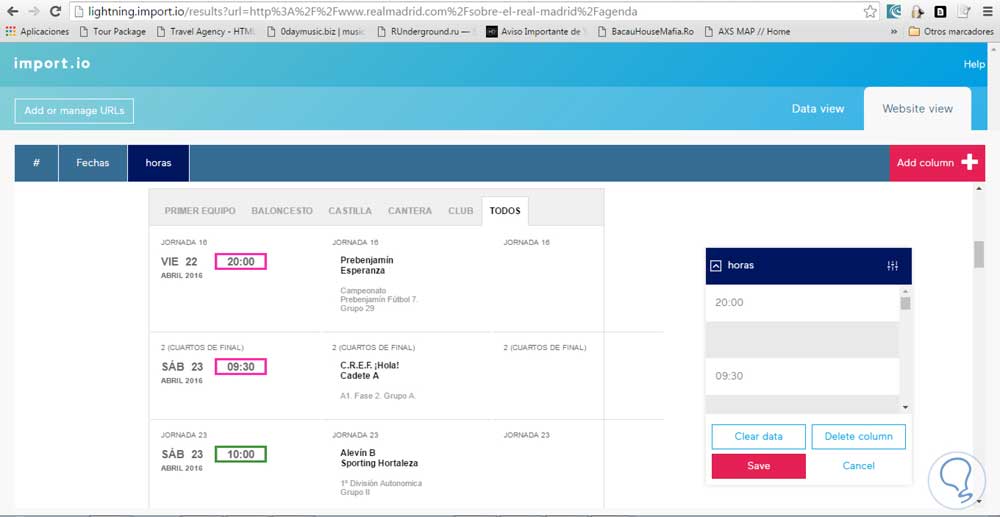

Para agregar otra columna, debemos estar dentro de la pestaña Website View y hacemos clic en el botón Add Column.

En nuestro caso le dimos el nombre de Horas y seleccionamos todos los elementos de la tabla que están en la página y contienen la hora.

Paso 6

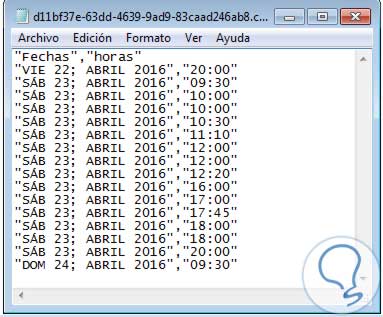

Salvamos los cambios hechos en esa columna y nos vamos a la pestaña Data View para ver cómo está quedando nuestro scraping.

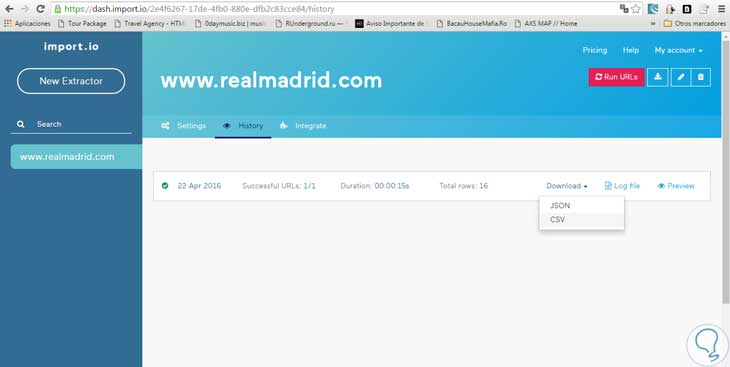

Así sucesivamente podemos ir agregando columnas de datos a nuestro documento scraping. Para finalizar hacemos clic en el botón Save Extractor, el cual nos llevará a otro panel donde se listarán las URLs a las que le hemos hecho scraping con import.io.

Nos mostrará la opción de programar la extracción de los datos cada cierto tiempo (Diario, semanal o mensual). En nuestro caso, no haremos esto y para poder guardar nuestro archivo, ya sea en formato CSV o JSON, nos pedirá que primero le demos clic a la opción Run URLs, luego de esto sí podremos bajar el archivo generado.

Paso 7

En nuestro caso seleccionaremos la opción CSV. El cual nos dará un archivo como el siguiente: