Los motores de búsqueda cuando llegan a un sitio Web comienzan a buscar el archivo robots.txt para proceder a su lectura. Va a depender de su contenido para que la araña de buscador continúe dentro del sitio o se dirija a otro.

El archivo robots.txt contiene una lista de páginas que son permitidas indexar al motor de búsqueda, a su vez restringe el acceso de forma selectiva a determinados motores de búsqueda.

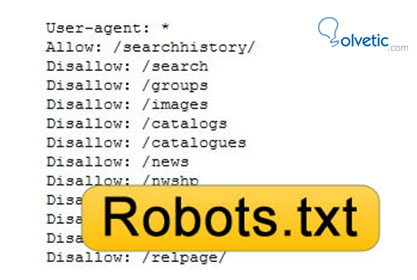

Se trata de un archivo ASCII que debe estar ubicado en la raíz del sitio. Los comandos que puede contener son:

Usuario agente: Es utilizado para especificar qué robot seguirá las órdenes que se presentan.

No permitir: Es usado para identificar qué páginas van a ser excluidas durante el proceso de análisis por parte del motor de búsqueda. Es importante que cada página que se va a excluir deba estar líneas separadas y además deben comenzar con el símbolo /. Con esta simbología se está especificando; a "todas las páginas del sitio web".

Es sumamente importante que el archivo robots.txt no tenga ninguna línea vacía.

Seguidamente se muestran algunos ejemplos;

Otra de las características es impedir la indexación de contenidos duplicados que se encuentran en el sitio, para de esta manera no ser penalizados.

Otras consideraciones a tener en cuenta es que algunos robots pueden ignorar las instrucciones que se presenten en este archivo, y además se debe tener en claro que el archivo es público ya que cualquier persona que escriba www.ejemplo.com/robots.txt puede tener acceso al mismo.

Ahora la pregunta puede ser; ¿Cómo generar el archivo robots.txt?

En realidad es bastante sencillo ya que se trata de un documento de texto con el nombre “robots.txt” para luego subirlo a la raíz del dominio de la página, es allí en donde los buscadores lo van a ir a buscar para su lectura.

Un archivo robots.txt básico puede ser:

User-agent: *

Disallow: /privado/

Se generan instrucciones para denegar el acceso a un directorio que será “privado” para todos los buscadores.

La orden determina que va dirigida a todos los robots (User-agent: *), especificando que el directorio es desautorizado (Disallow: /privado/).

El parámetro que se utiliza para el motor de búsqueda de Google es; User-agent: Googlebot

Como se mencionó anteriormente su uso en SEO es usado para restringir el acceso de los robots a contenido duplicado.

El archivo robots.txt contiene una lista de páginas que son permitidas indexar al motor de búsqueda, a su vez restringe el acceso de forma selectiva a determinados motores de búsqueda.

Se trata de un archivo ASCII que debe estar ubicado en la raíz del sitio. Los comandos que puede contener son:

Usuario agente: Es utilizado para especificar qué robot seguirá las órdenes que se presentan.

No permitir: Es usado para identificar qué páginas van a ser excluidas durante el proceso de análisis por parte del motor de búsqueda. Es importante que cada página que se va a excluir deba estar líneas separadas y además deben comenzar con el símbolo /. Con esta simbología se está especificando; a "todas las páginas del sitio web".

Es sumamente importante que el archivo robots.txt no tenga ninguna línea vacía.

Seguidamente se muestran algunos ejemplos;

- Cuando se desea excluir todas las páginas; el Usuario agente es: No permitir:/.

- Si el objetivo es que no se excluya a ninguna página, entonce el archivo robotos.txt no debe existir en el sitio Web, es decir que se visitarán todas las páginas del sitio por igual.

- Cuando se excluye a un robot determinado será:

- Usuario agente: Nombre del robot No permitir: / Usuario agente: * No permitir:

- Cuando se excluye una página; Usuario agente: * No permitir: /directorio/ruta/página.html

- Cuando se excluyen a todas las páginas de un directorio del sitio Web con sus correspondientes subcarpetas, será; Usuario agente: * No permitir: /directorio/

Otra de las características es impedir la indexación de contenidos duplicados que se encuentran en el sitio, para de esta manera no ser penalizados.

Otras consideraciones a tener en cuenta es que algunos robots pueden ignorar las instrucciones que se presenten en este archivo, y además se debe tener en claro que el archivo es público ya que cualquier persona que escriba www.ejemplo.com/robots.txt puede tener acceso al mismo.

Ahora la pregunta puede ser; ¿Cómo generar el archivo robots.txt?

En realidad es bastante sencillo ya que se trata de un documento de texto con el nombre “robots.txt” para luego subirlo a la raíz del dominio de la página, es allí en donde los buscadores lo van a ir a buscar para su lectura.

Un archivo robots.txt básico puede ser:

User-agent: *

Disallow: /privado/

Se generan instrucciones para denegar el acceso a un directorio que será “privado” para todos los buscadores.

La orden determina que va dirigida a todos los robots (User-agent: *), especificando que el directorio es desautorizado (Disallow: /privado/).

El parámetro que se utiliza para el motor de búsqueda de Google es; User-agent: Googlebot

Como se mencionó anteriormente su uso en SEO es usado para restringir el acceso de los robots a contenido duplicado.